Así se propaga la posverdad

Así se propaga la posverdad

¿Por qué a veces los datos objetivos tienen menos valor que las opiniones? ¿Cómo operan los sesgos y las emociones en la génesis de la posverdad? Cuatro libros recientes sobre el tema nos acercan algunas respuestas.

Augusto Laros

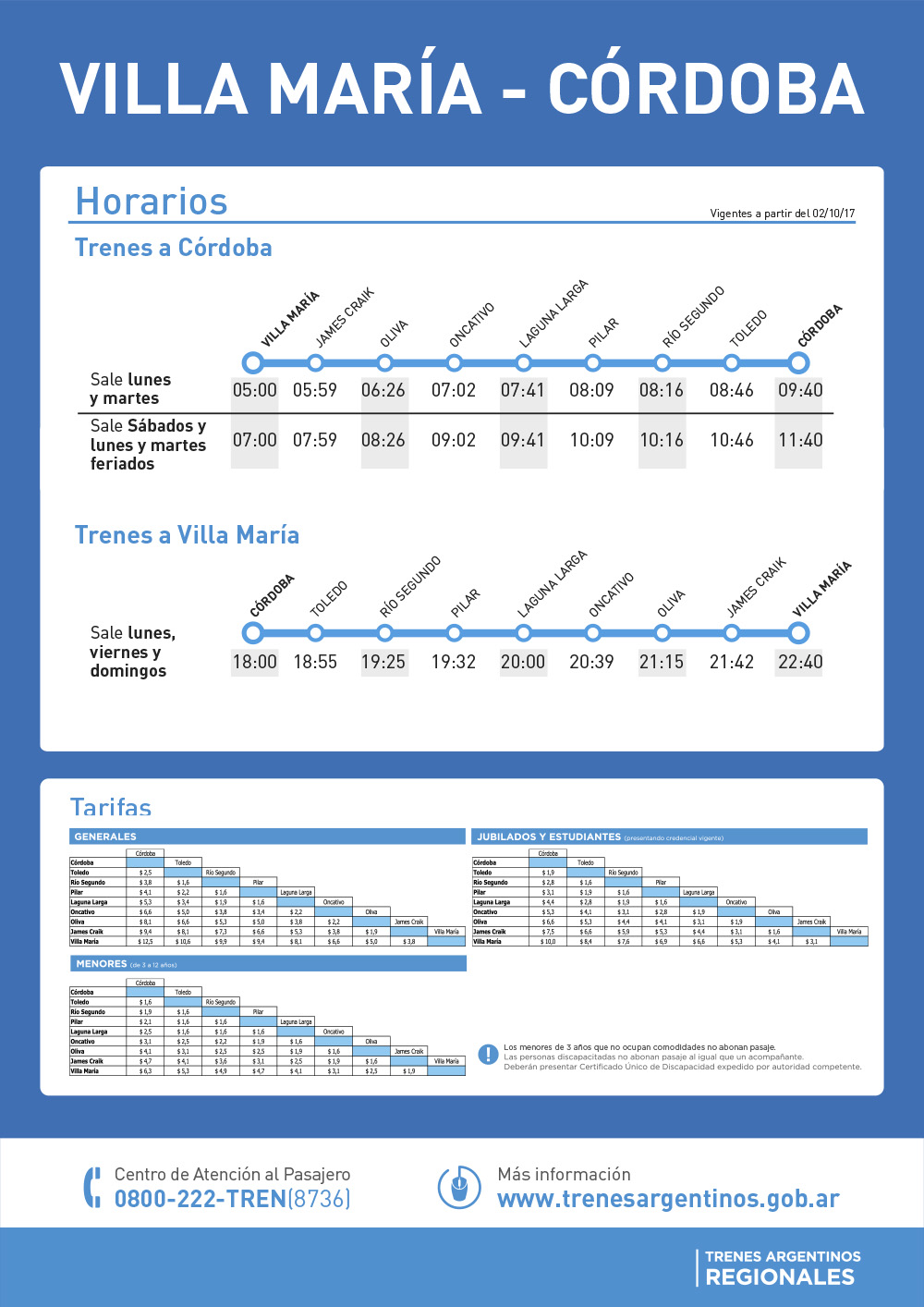

El 9 de noviembre de 2016, la mañana siguiente a la elección que llevó a Donald Trump a la presidencia de los Estados Unidos, el republicano Mr. Tucker acusó a los demócratas de haber transportado militantes anti-Trump a una marcha en Austin, Texas.

Ese día, Mr. Tucker observó una gran cantidad de autobuses de larga distancia estacionados cerca de donde se realizaba una protesta en contra de la victoria de Donald Trump.

Tucker publicó un tuit con la foto de los autobuses acompañada de la frase “La protesta anti-Trump no es tan orgánica como parece. Aquí están los autobuses en los que vinieron”. Aquel tuit se imprimió en los muros de millones de usuarios.

Los autobuses, sin embargo, no transportaban militantes anti-Trump, sino alrededor de 13 mil profesionales que habían pagado su entrada a una conferencia sobre tecnología.

Al descubrir su “error”, Mr. Tucker borró el tuit original y publicó una retracción. Pero las imágenes del tuit ya borrado seguían propagándose, diseminadas por cientos de miles de usuarios conservadores. La corrección, en cambio, languidecía en el muro de Tucker.

Además, al reconocer su error, Tucker sufrió el abandono de su comunidad de pertenencia. Pese a la aclaración que hizo, es posible que todavía muchas personas sigan sosteniendo que ese 9 de noviembre efectivamente hubo una marcha anti-Trump.

Este ejemplo, extraído del libro Fake News, trolls y otros encantos, de los autores Ernesto Calvo y Natalia Aruguete, vale para reflexionar sobre cómo se construye la posverdad y también sobre cómo se propaga.

El libro revela, entre otras cosas, los mecanismos que surgen frente a un evento político en las redes sociales: “Se inicia con las creencias de un usuario que transforma sus prejuicios en información, continúa con la maquinaria mediática y política que le da impulso a su mensaje y concluye con la viralización del contenido”. Llegado a este punto, es tarde para aclaraciones.

En la posverdad, y tal como demuestra el caso de Mr. Tucker, la verdad es hecha a un lado y se prioriza en cambio la percepción propia acerca del mundo.

¿Qué pasó en el caso de Mr. Tucker?

Para explicarlo, Calvo y Aruguete hablan de preactivación. Es decir, preparar a un sujeto para que sea sensible a una determinada línea argumental.

“Su búsqueda estuvo inclinada a encontrar el apoyo empírico que confirmase su hipótesis”, señalan los autores.

A este fenómeno se lo conoce como “razonamiento motivado”, que define el mecanismo cognitivo por el cual, con un resultado ya en mente, tendemos a aceptar evidencia que sostenga nuestra conclusión o a descartar aquella que la contradiga.

Un experimento social, incluido en Fake News, sirve para mostrar cuán lejos puede llegar nuestro razonamiento motivado.

Durante su asunción en 2017, Donald Trump aseguró que la participación ciudadana marcaba posiblemente un nuevo récord en ese país. De inmediato comenzaron a circular imágenes que la compararon con la ceremonia de Barack Obama en 2009.

Según analistas independientes, a la asunción de Trump asistieron entre 300 y 600 mil personas, menos de la mitad de las que asistieron a la de Obama. Pese a todo, muchos republicanos afirmaban que en el acto de Trump hubo más personas que en el de Obama.

Con el objetivo de entender lo que estaba pasando, se diseñó un trabajo en el que a un grupo de encuestados se les mostraron las imágenes con las asunciones de Trump y de Obama. Tras indicarles cuál era la imagen de la asunción de Trump, se les preguntó en cuál de esos actos había más gente.

En promedio, un 15 por ciento de los republicanos respondió que había más gente en la de Trump, pese a que en las imágenes se veía claramente que no era así.

En estos casos, los especialistas hablan de “ruptura del consenso cognitivo”. Ocurre cuando dudamos de los resultados por nuestras creencias previas.

La escritora francesa Ruth Amossy, especialista en argumentación y análisis del discurso, dice que la neutralidad es el único recurso para comprender la lógica de unos y otros. “El esfuerzo por no tomar partido parece la mejor opción para observar los debates polémicos”, plantea.

Terreno fértil

Para Guadalupe Nogués, autora del libro Pensar con otros, la desinformación, que puede conducir a la posverdad, encuentra terreno fértil en la intuición, en las tradiciones y en la falsa sensación de que sabemos cómo son las cosas.

“Creemos que sabemos muchas cosas, aunque individualmente sabemos muy poco, porque tratamos el conocimiento de los demás como si fuera propio”, reflexiona el historiador iraní Yuval Harari.

Nogués propone, para aproximarnos a la verdad, que diseñemos procedimientos que no dependan tanto de nosotros.

Ocurre que para entender los distintos fenómenos sociales las personas tendemos a simplificarlos, con el riesgo de distorsionar que eso conlleva.

Harari habla de cuatro vicios como fuentes de posverdad: minimizar la cuestión; centrarse en una historia humana conmovedora, que presumiblemente representa todo el conflicto; pergeñar teorías conspiratorias y, por último, crear un dogma.

Nogués agrega el negacionismo y el relativismo extremo como otras fuentes de la posverdad.

Salir del laberinto no resulta una tarea sencilla. Detectarla nos exige, entre otras cosas, un enorme esfuerzo de introspección.

Atajos emocionales

En su libro 21 Lecciones para el siglo XXI, Yuval Harari plantea que los expertos en economía conductual y los psicólogos evolutivos han demostrado que la mayoría de las decisiones humanas se basan en reacciones emocionales y atajos heurísticos más que en análisis racionales.

Dice Harari que mientras nuestras emociones quizá fueran adecuadas para afrontar la vida en la Edad de Piedra, resultan inconvenientes para la época actual.

Nogues afirma que las emociones modulan la manera en la que recibimos o incorporamos la información. “Si un tema despierta una fuerte respuesta emocional, es posible que surja la posverdad”, señala.

Para esta autora, si a las creencias que van en contra de las evidencias que existen le sumamos un componente emocional, lo que tenemos es un cóctel de posverdad.

Sobre este punto Ruth Amossy sostiene, en su libro Apología de la Polémica, que los sentimientos (metidos en la discusión pública) paralizan la reflexión y no permiten pensar serenamente en los pro y los contra de una tesis en debate.

Aunque se sabe que muchas veces nuestras posturas se apoyan en creencias irracionales, “solemos creer que las evidencias nos llevaron a ella”, dice Nogués. En este autoengaño aparece otra de las formas de la posverdad.

Sesgos y tribus

Hay otros factores que dificultan todavía más el asunto. Uno de ellos es el “sesgo de confirmación”, que nos lleva a buscar, a interpretar y a recordar la información que confirma las propias creencias.

Los especialistas coinciden en que la gente rara vez es consciente de su ignorancia, porque se rodea de personas que tienen ideas parecidas y de noticias que se confirman a sí mismas. Y esto da lugar a otro problema: la conformación de tribus.

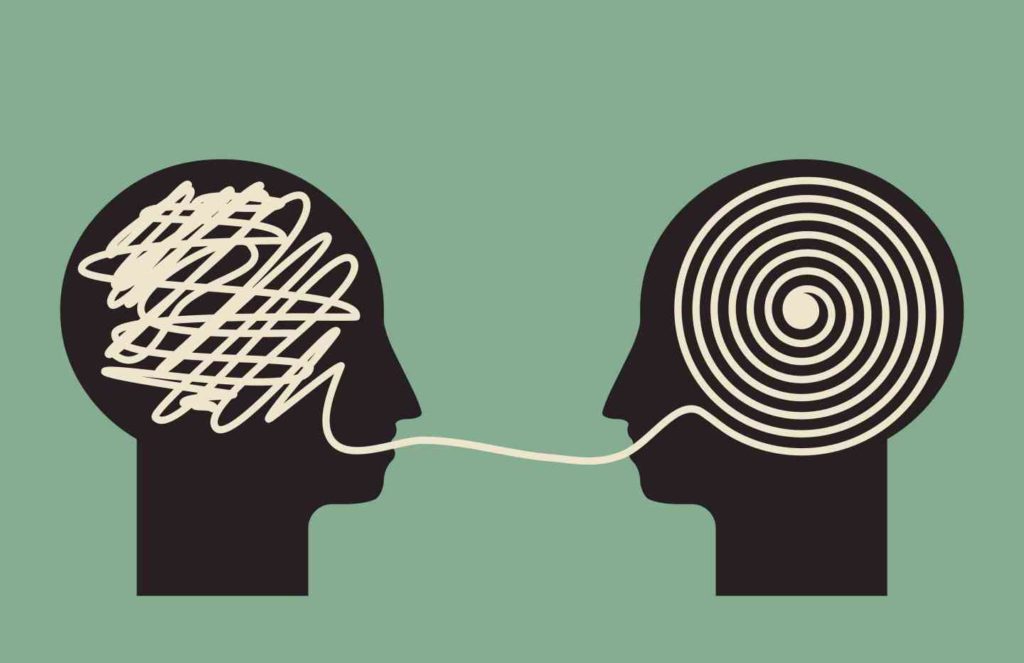

“Nos agrupamos con personas que piensan como nosotros y excluimos a los que no. Con el tiempo, la única opinión que escuchamos es la de gente que piensa como nosotros. Y todo esto en un esfuerzo involuntario por no cambiar de opinión”, explica Nogués.

Así, plantean los especialistas, las diferencias entre grupos aumentan, el diálogo disminuye y el “otro” se convierte en un enemigo.

Algunas investigaciones sostienen que cuando un grupo formado por personas con posturas similares discute sobre un tema de política, la actitud de cada persona se vuelve más extrema luego de la discusión. Esto se conoce como polarización de grupo o lealtad al grupo.

Por eso proponen desafiar al tribalismo. Aunque, como dice Nogués, pocas cosas son más difíciles para un animal social como nosotros que salir de un grupo de pertenencia: dejar las tribus suele acarrear un alto costo emocional.

¿Alcanza con dar mayor información?

Si bien se cree que cuanto más abundante es la información estadística menos influencias tienen las creencias previas en el resultado final, esto no bastaría para que alguien cambie de ideas, aunque sean equivocadas.

Nogués lo explica así: “Si esto fuera cierto, esperaríamos que darles la información que les falta fuera suficiente para que cambie de postura. (…) Muchas veces se observa que, si alguien ya tiene una postura sobre un tema, y esta postura está equivocada, tratar de corregirla dándole la información correcta no logra que cambie de opinión”.

Harari va más allá y habla de sesgos estructurales. Dice que la mayoría de las injusticias en el mundo contemporáneo surgen de sesgos estructurales a gran escala más que de prejuicios individuales. Y explica que nuestro cerebro de cazadores-recolectores no ha evolucionado para detectarlos.

Para luchar contra la posverdad, Nogués propone vivir en una actitud de sano escepticismo respecto de los hechos, especialmente con aquellas afirmaciones con las que estamos de acuerdo. Cuando nos llega información, dice la autora, deberíamos averiguar de dónde y cómo viene. “Tenemos que preguntarnos qué información no nos está llegando”, dice.

También señala la necesidad de que haya ciudadanos científicamente alfabetizados y enfatiza en que la curiosidad es un buen antídoto contra la posverdad.